“Mankind is no longer alone” – Über den Sinn und Unsinn der Asimov’schen Roboter-Gesetze

Von Isabella Hermann (Berlin)

“There was a time when humanity faced the universe alone and without a friend. Now he has creatures to help him; stronger creatures than himself, more faithful, more useful, and absolutely devoted to him. Mankind is no longer alone.”

Dieses Zitat stammt nicht etwa von dem japanischen Robotiker Hiroshi Ishiguru, der humanoide Roboter nach seinem eigenen Abbild herstellt, die ihn bei Vorträgen vertreten, sondern von der fiktiven Roboterpsychologin Susan Calvin aus der Kurzgeschichtenreihe „I, Robot“ des berühmten Science-Fiction-Autors Isaac Asimov. In seinen in den 1940ern und 1950ern verfassten Science-Fiction-Geschichten geht es mit der Entwicklung intelligenter Maschinen ab Anfang der 2000er Jahre richtig los. Susan Calvin wird aus der Zukunftsperspektive der Geschichten im Jahr 1982 geboren, in demselben Jahr, in dem der für den technischen Fortschritt verantwortliche Konzern „U.S. Robot and Mechanical Men Co.“ gegründet wird. Die promovierte Kybernetikerin heuert dort im Jahr 2008 als „Robopsychologist“ an, und steigt ab spätestens 2029 zur „Head Psychologist“ auf. Bevor sie mit 82 Jahren im Jahr 2064 stirbt, erzählt sie einem jungen Journalisten ihre Erlebnisse – die Ausgangslage für die „I, Robot“-Serie. In dieser alternativen Zukunft (bzw. Gegenwart) produziert „U.S. Robots“ – wie das Unternehmen abgekürzt wird – Roboter, die den Menschen in vielen Lebensbereichen unterstützen und helfen – vom Kinderbetreuer bis zum Industriearbeiter. Es gibt aber auch Supercomputer, die für die Menschen komplexe Probleme lösen und komplizierte Management-Aufgaben übernehmen.

Die Roboter und Maschinen funktionieren dank eines positronischen Gehirns, das mit dem berühmten hierarchisch aufeinander aufbauenden Asimov’schen Roboter-Gesetzen programmiert ist, damit jene Menschen keinen Schaden zufügen können:

- Ein Roboter darf kein menschliches Wesen verletzen oder durch Untätigkeit zulassen, dass einem menschlichen Wesen Schaden zugefügt wird.

- Ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen – es sei denn, ein solcher Befehl würde mit Regel eins kollidieren.

- Ein Roboter muss seine Existenz beschützen, solange dieser Schutz nicht mit Regel eins oder zwei kollidiert.

Diese wurden später durch ein „Nulltes“ Gesetz ergänzt:

- Ein Roboter darf die Menschheit nicht verletzen oder durch Passivität zulassen, dass die Menschheit zu Schaden kommt.

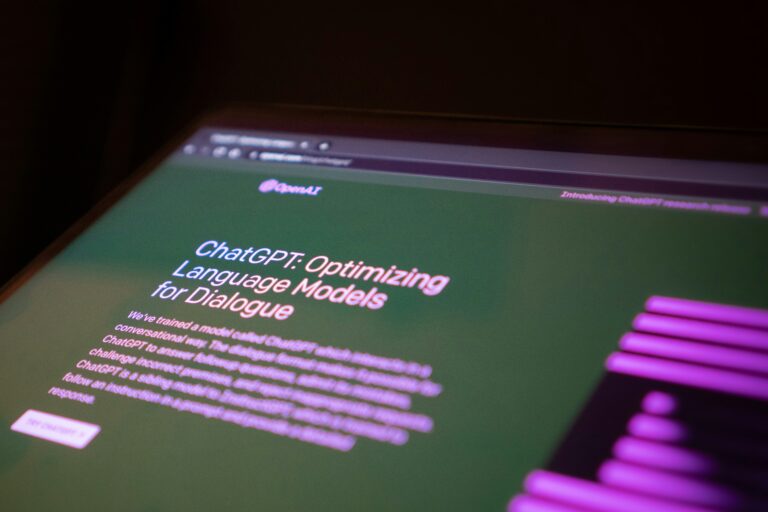

Vor allem seit dem Boom um Künstliche Intelligenz (KI) ab den 2010er Jahren werden die Asimov’schen Roboter-Gesetze von den Medien gern zitiert, wenn es darum geht, wie Maschinen, Computer und Roboter designt werden sollten, damit sie von sich aus im menschlichen Sinne ethisch handeln. Diese Diskussion ist von vorneherein fehlerhaft und basiert auf zwei großen Missverständnissen. Zum einen können Maschinen aus sich heraus nicht ethisch handeln. Gutes ethisches Verhalten lässt sich nicht programmieren, weil es zu komplex ist. Schon allein die Vorgabe, dass Lügen an sich unmoralisch, aber in bestimmten Kontexten unabdingbar ist, ist nicht in Code zu fassen. Allerdings lässt sich gutes Verhalten auch nicht durch selbstlernende Systeme – auf denen das aktuelle Verständnis von KI basiert – aus Datenbeständen herausfinden, gerade weil Menschen eben nicht immer gut handeln. Gutes ethisches Handeln ist ein Ideal, an dem sich unsere Gesellschaften reiben, es ist weder an sich programmierbar, noch aus dataisiertem Verhalten der Menschen in Code zu fassen.

Was allerdings noch viel grundlegender ist, ist gar nicht die technische Umsetzbarkeit, sondern – zum zweiten – die diskursive Konstruktion, dass die Gesetze von Asimov tatsächlich etwas über den Umgang mit Technologie aussagen würden. Damals „I, Robot“ wie heute andere Science-Fiction-Stories wie beispielsweise „Matrix“, „Ex Machina“ oder der neue „Terminator“, spielen natürlich vor dem Hintergrund rasanter technischer Entwicklung – aber sie sind in erster Linie Geschichten von und für Menschen, nicht Geschichten über Technik. Die Robotergesetze von Asimov sind aus erzähl-strategischer Perspektive ein Mittel bzw. ein Gag, um die Story am Laufen zu halten. Sie können gar nicht funktionieren, weil sie den Geschichten die Dramaturgie, Konflikte und Paradoxien bescheren, die sie erst für die Leser*innen spannend und witzig machen. Schließlich entstehen laufend die absurdesten Situationen, weil die Roboter und Maschinen in Konflikt mit den Gesetzen geraten, wobei Susan Calvin herangezogen wird, um das rätselhafte Verhalten zu entschlüsseln. Das nullte Gesetz wurde später ergänzt, weil es eine narrative Notwendigkeit in der letzten Geschichte über Computersysteme gab, die die globale Wirtschafsproduktion steuern, nicht weil Asimov plötzliche eine Eingebung hatte, dass wir uns als Menschheit global vor Computern schützen müssen.

Die Roboter-Geschichten zeigen zwar die Komplexität von Ethik und Moral, und sie sind sehr unterhaltsam, aber sie verorten das ethische Dilemma – wie die anderen genannten Film-Beispiele ebenso – in der Maschine selbst. Dabei werden die Risiken bei der Entwicklung immer „intelligenterer“ Computersysteme auf einen Konflikt des Menschen gegen die Maschine reduziert und – unbewusst und bei bestimmten Interessensgruppen sicherlich absichtlich – davon abgelenkt, das weiterhin Menschen hinter der Entwicklung von solchen Computersystemen stehen. Die Frage ist nicht die eines Kampfes des Menschen gegen die smarte Maschine, sondern was auf KI-basierende Technik für zwischenmenschliche und gesellschaftliche Folgen hat. Eine reale Problematik von KI-Systemen ist beispielsweise die mögliche Verfestigung von Ungerechtigkeiten durch verzerrende Diskriminierungen in Datensätzen. Wie eingangs erwähnt, basiert KI derzeit auf Maschinellem Lernen, dessen Grundlage Datenmengen sind, also nichts anderes als der digitalisierte Erfahrungsschatz der Menschen. Diese Daten reflektieren die Ungleichheiten der Geschichte, beispielsweise die strukturelle Benachteiligung von Frauen oder institutionelle Rassismen gegenüber Menschen mit nicht-weißer Hautfarbe. Wird ein Prognosesystem auf Grundlage solcher Daten trainiert, überträgt es die Ungleichheiten in die Zukunft. Beispiele hierfür sind ein internes Recruiting-Tool von Amazon, das aus alten Bewerberdaten „lernte“, dass Männer die optimalen Kandidaten für Tech-Jobs bei Amazon seien – was eine männliche Dominanz in der Tech-Industrie nicht besser illustrieren könnte. Nicht das System ist frauenfeindlich, es zeigt eine bestehende Benachteiligung. Wird diese nicht entdeckt, verfestigen sich vorherrschende Machtstrukturen und werden nicht etwa bekämpft, sondern in die Zukunft übertragen und zementiert.

KI handelt nicht für sich selbst, sondern spiegelt vielmehr die Entscheidungen der Programmierer und Datenwissenschaftler wider und zeigt sich in der Anwendung in der Mitte unserer Gesellschaft. Science-Fiction-Stories sind voll von Prinzipien und Regeln, die wünschenswert erscheinen, aber von vorneherein unerfüllbar sind – sie liefern und den Stoff für spannende Geschichten.

Dr. IsabellaHermann ist Politikwissenschaftlerin. Sie untersucht, wie in der Science-Fiction – dem Genre der Zukunft – der technische Fortschritt dargestellt wird, welche Auswirkungen Technologie auf die uns bekannten sozialpolitischen Strukturen hat und was uns das über unsere Gegenwart verrät. Aktuell koordiniert Isabella Hermann die interdisziplinäre Arbeitsgruppe „Verantwortung: Maschinelles Lernen und Künstliche Intelligenz“ der Berlin-Brandenburgischen Akademie der Wissenschaften in Berlin.