Verantwortung und Künstliche Intelligenz

von Philipp Kellmeyer (Freiburg)

Technologische Konvergenz: Digitalisierung, Big Data, Deep Learning

Künstliche Intelligenz (KI) ist, zusammen mit Digitalisierung und Big Data, ein zentrales Schlagwort und Sinnbild für einen umfassenden technosozialen Wandel. Digitalisierung umfasst im Wesentlichen die Transformation der informationstechnologischen (IT) Infrastruktur—mit dem Ziel systematisch Daten digital erfassen, aufbereiten und verwerten zu können. Erfolgreiche Digitalisierung bedeutet in diesem Sinne, dass sektorspezifisch, beispielsweise in der Medizin oder dem Verkehrswesen, Dateninfrastrukturen aufgebaut werden, die die systematische Verfügbarkeit von großen Datenmengen (big data) zur Analyse mit fortgeschrittenen Methoden des maschinellen Lernens, oftmals idealiter in Echtzeit, ermöglichen.

In der medialen Berichterstattung und öffentlichen Debatte wird dabei in der Regel von KI, KI-Methoden, oder KI-Systemen gesprochen. KI umfasst jedoch eine ganze Reihe unterschiedlicher Methoden aus der Informatik und Datenwissenschaft (data science) die jeweils mehr oder weniger Bedeutung in der derzeitigen Anwendung haben. Vereinfacht lässt sich jedoch sagen, dass die wesentlichen Erfolge der letzten Jahre—ob im Bereich der Robotik, des autonomen Fahrens oder in der Medizin—ganz überwiegend durch Software-Architekturen erzielt wurden, die auf künstlichen neuronalen Netzen (artificial neural networks, ANN) für tiefes Lernen (deep learning) beruhen. Solche ANNs für Deep Learning werden beispielsweise für Online-Übersetzungsprogramme, Sprachassistenzsysteme oder Navigationssysteme und viele andere Anwendungen bereits genutzt, so dass die meisten Menschen bereits im Alltag heute regelmäßig und intensiv mit KI-Systemen interagieren.

In der Medizin haben sich in den letzten Jahren insbesondere Verfahren der automatisierten Analyse von Bilddaten, mit ANNs und Deep Learning als erfolgreich erwiesen, beispielsweise in der Erkennung bösartiger Hautveränderungen (Esteva et al., 2017). Deep Learning wird daher von vielen Expertinnen und Experten als die treibende Technologie für eine Transformation des Gesundheitswesens und der klinischen Versorgung der Zukunft gesehen (Hinton, 2018; Topol, 2019). Ob in der Medizin, dem Verkehrswesen oder im Hinblick auf autonome Waffensysteme, ergeben sich aus dieser technosozialen Transformation erhebliche ethische, rechtliche und gesellschaftliche Herausforderungen, von denen ich im Folgenden den Begriff der Verantwortung ins Zentrum der Überlegungen stellen möchte.

Verantwortung und Verantwortlichkeit

Alltagssprachlich unterscheiden wir zwischen Verantwortung und Verantwortlichkeit, allerdings nicht immer konsistent und nicht immer trennscharf: Verantwortung kann von einem Individuum aktiv übernommen werden oder diesem übertragen werden—zeitlich zumeist der zu verantwortenden Handlung vorausgehend. Verantwortlichkeit hingegen wird eher von außen zugeschrieben, zeitlich eher im Nachgang eines Ereignisses (meist mit entweder eher positiver oder eher negativer Konnotation). Das Englische kennt zudem die Unterscheidung zwischen „responsibility“ und „accountability“, die ebenfalls zum einen eher die aktive Verantwortungsübernahme (responsibility) zum Einen und die Verantwortungszuschreibung (accountability) für Handlungen bezeichnen.

Aus philosophischer Sicht bietet die Nähe von Verantwortung zu handlungsorientierten Begriffen („Übernahme“, „Zuschreibung“) Anknüpfungspunkte zur Handlungstheorie (theory of actions), insbesondere dem Konzept der agency. So ließe sich aus systematischen Erwägungen heraus diskutieren, ob und inwieweit überhaupt Verantwortung übernommen oder Verantwortlichkeit zugeschrieben werden kann, wenn das zugehörige (moralische) Subjekt keine Handlung vollzogen hat, die sinnvollerweise dem Eintreten eines Ereignisses zugeordnet werden könnten.

Die britische Philosophin Onora O’Neill (und andere Autor*innen) unterscheiden auch zwischen einer Verantwortung 1. Ordnung (first order responsibility)—z.B. Eltern sind verantwortlich dafür, die Sicherheit ihrer Kinder zu gewährleisten—und Verantwortung zweiter Ordnnug (second order responsibility), welche sich auf Änderungen in der (individuellen oder gesellschafltichen) Priorisierung und/oder der Bedingungen zur Übernahme (oder Zuschreibung) bestimmter Verantwortlichkeiten (possible action schemes) bezieht (O’Neill, 2013). So wäre beispielsweise auf den Verkehr bezogen die Verantwortung erster Ordnung von politischen EntscheidungsträgerInnen und Regulierungsbehörden gegenüber den BürgerInnen, die Sicherheit existierender Beförderungsmittel sicherzustellen (z.B. durch Verkehrsregeln, Gurtpflicht etc.), während die Verantwortung zweiter Ordnung die Frage beträfe, ob und inwieweit ein bestimmtes gesellschaftliches Gut wie individuelle Mobilität mit relevanten negativen gesellschaftlichen Folgen (Verkehrstote, Umweltbelastung durch Kraftfahrzeuge), gegenüber einem anderen Gut (wie der Freiheit von Gefährdung durch Verkehrsunfälle oder Luftverschmutzung) priorisiert werden sollte.

Mensch-KI Interaktion

Auf KI-Systeme bezogen kommt nun zu dem ohnehin schon komplexen Verantwortungsgeflecht aus Individuen, gesellschaftlichen Institutionen und anderen Funktionsträgern (z.B. Industriedesignern u.a.) und Akteuren, ein weiteres Element hinzu: ein adaptives, lernfähiges KI-System dessen interne Lerndynamik—zumindest bislang—in der Regel nicht genau verstehbar und dessen zukünftiges Verhalten daher nicht hinreichend genau vorhersehbar ist.

Durch die zunehmende Präsenz von KI-Systemen in unserem Alltag stellt sich daher u.a. die Frage, welchen gesellschaftlichen Akteuren es nun im besonderen Maße obliegt, die verantwortliche Entwicklung und Nutzung von KI-Systemen (im Allgemeinen und bezogen auf die jeweiligen Anwendungsszenarien und Sektoren) zu gestalten und zu bestimmen.

Nehmen wir ein fiktives Fallbeispiel aus dem Gesundheitsbereich: Angenommen, ein Unternehmen entwickelt ein „smartes“ KI-basiertes Diagnosesystem, welches Ärztinnen und Ärzten im vollständig digitalisierten Datenökosystem einer Klinik der Zukunft assistieren soll. Das System names „KIDoc“ kann dabei alle möglichen Datentypen—Bilddaten aus radiologischen Untersuchungen, Daten aus der digitalen Patientenakte, Smartphonedaten des Patienten usw.—in einer großen Datenbank integrieren, analysieren und für den Gebrauch nutzerfreundlich und graphisch ansprechend aufbereiten. In einem typischen Anwendungsszenario würde beispielsweise eine Ärztin in ihrem Sprechzimmer in der Ambulanz einen Patienten empfangen und könnte mittels eines computerbasierten Nutzerinterface die Daten aus KIDoc per Spracheingabe bekommen („KIDoc, welche Untersuchungen wurden bei Herrn Müller während des letzten Aufenthaltes durchgeführt und wie waren die Ergebnisse?“).

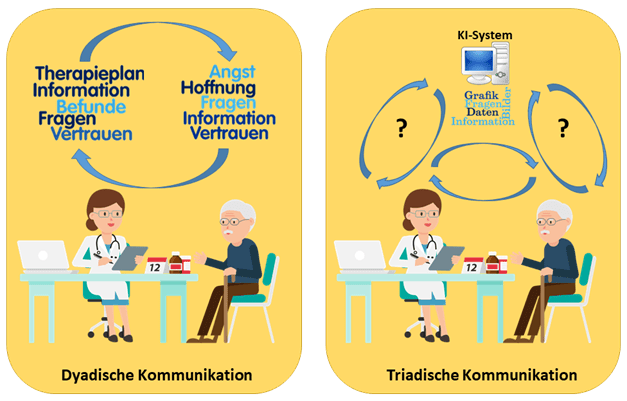

Ein zentraler Aspekt ist dabei, dass die (üblicherweise) dyadische Kommunikation zwischen Ärztin und Patient mit dem KI-Assistenten um ein drittes Element erweitert wird, welches je nach Grad der Automatisierung und Autonomie mitunter als selbständig agierendes Gegenüber wahrgenommen wird (siehe Abbildung 1).

Abb. 1: Aus der dyadischen Kommunikation zwischen Ärztin und Patient entsteht ein kommunikatives Dreieck aus Ärztin, KI-System und Patient. Ungeklärt ist bislang, inwiefern diese Konstellation das Kommunikationsverhalten und das Vertrauensverhältnis zwischen Ärztin und Patient beeinflusst.

Wenn wir uns das Szenario bis zu diesem Punkt vorstellen, stellen sich sogleich etliche Fragen, wie die Interaktion zwischen Ärztin, Patient und KI-System idealerweise gestaltet werden soll, um sowohl den Bedürfnissen der Ärztin als auch des Patienten gerecht zu werden.

Zur verantwortlichen Gestaltung der Mensch-KI Interaktion

Die zunehmende Präsenz von assistiven KI-Systemen, ob in der Medizin, im Verkehr oder der industriellen Fertigung, erfordert eine gesellschaftliche Auseinandersetzung mit der Frage der Verantwortungsaufteilung und –zuschreibung in Fällen enger Mensch-KI Interaktion. Dabei sollte neben der Art der Verantwortung (1. Ordnung, 2. Ordnung) auch jeweils die Träger*innen derselben klar benannt werden. Da jedoch, zumindest in den meisten systematischen Überlegungen in der Moralphilosophie und Rechtsphilosophie, die Übernahme oder Zuschreibung von Verantwortung ein moralisches Subjekt als Verantwortungsträger*in erfordert, stellt sich in Bezug auf KI-Systeme die Frage, inwieweit diese überhaupt als moralisches Subjekt (moral agent) erkannt bzw. anerkannt werden können. Dies ist insofern relevant, als in solchen Fällen in denen KI-Systeme zu autonomen oder teilautonomen Entscheidungsträgern werden, mitunter Verantwortlichkeitslücken entstehen können, für deren Überbrückung unsere Gesellschaften zurzeit noch nicht über ein ausdifferenziertes System der rechtlichen, finanziellen, geschweige denn individualpsychologischen Abgeltung verfügen (Kellmeyer et al., 2016).

Nehmen wir als Fallbeispiel folgendes Szenario: Ein vollautonomes Fahrzeug, welches durch ein KI-System gesteuert wird, kollidiert mit einer Fußgängerin und diese verstirbt an den Folgen der Kollision. Aus den ausgelesenen Daten des Fahrzeugs lassen sich keine klaren Schlüsse ziehen, welche Parameter das selbstfahrende Fahrzeug—welches bis dato stets fehlerfrei gefahren ist—zur Entscheidung veranlasst haben, in die Passantin zu steuern. Nun gibt es in diesem Fall, anders bei einem Unfall mit einem menschlichen Fahrer, kein eindeutiges moralisches Subjekt, welchem die Verantwortung zugeschrieben werden kann. Zwar kann der „Schaden“ durch Versicherungspolicen finanziell gegenüber der Familie der Passantin abgegolten werden, das urmenschliche Bedürfnis jedoch, dass ein moralisches Subjekt (also bislang ein Mensch) als Verantwortungsträger (über die reine Gefährdungshaftung hinaus) ermittelt wird und ggf. juristische Konsequenzen zu tragen hat, bleibt dann unerfüllt.

Nun könnte es à la longue, beispielsweisedurch einen gesellschaftlichen Drift in der Wertpriorisierung, durchaus dazu kommen, dass dieses individualpsychologische Bedürfnis nach Verantwortungszuschreibung auf moralische Subjekte zunehmend durch andere individuelle oder gesellschaftliche Prioritäten verdrängt wird. So könnte sich beispielsweise die durchschnittliche Einstellung dahingehend ändern, dass ein substanzieller (und auch für das Individuum spürbare) Zugewinn an Sicherheit im Verkehrswesen durch (teil)autonome Fahrzeuge das individualpsychologische Bedürfnis nach eindeutiger Zuschreibung der Verantwortungsträgerschaft mit der Zeit mildert. Andererseits könnte sich auch herausstellen, dass das Bedürfnis nach moralischen Subjekten als Verantwortungsträger eine unverrückbare anthropologische Konstante ist und es dann zunehmend zu Konflikten in Fällen missglückter Mensch-KI Interaktion kommt.

Dies könnte dann auch dazu führen, dass wir entweder die Kriterien für die Anerkennung des Status als moral agent verändern—in der Technikphilosophie wird im Hinblick auf autonome Roboter beispielsweise schon länger diskutiert, ob moral agency nicht auch eine abgestufte Eigenschaft eines Systems sein kann (Lin, Abney, & Jenkins, 2017). Ähnlich wie wir Menschen mit tiefgreifenden kognitiven Einschränkungen oder momentaner „Unzurechnungsfähigkeit“ nicht den vollen Status als moralisches Subjekt zuerkennen, so wäre es aus dieser Perspektive umgekehrt durchaus legitim, Systemen (z.B. einem KI-System), die im Hinblick auf ihr Verhalten und Interaktionsfähigkeit eine (Teil)autonomie erlangt haben, auch eine partielle moral agency (und somit Verantwortungsträgerschaft) zuerkennen.

Interessant ist dann diesem Zusammenhang die Frage, welche Design-Eigenschaften eines KI-Systems notwendig und hinreichend sind, damit Menschen im Allgemeinen bereits sind, das System als moralisches Subjekt anzuerkennen: sollte das System embodied sein, also über einen Körper verfügen? Wenn ja, sollte dieser eher menschenähnlich (z.B. humanoide Roboter) sein oder zählt bereits die wahrgenommene Autonomie und agency auf der Verhaltensebene (z.B. ein autonomer Staubsauger), um dem Objekt bestimmte Rechte zuzuerkennen und es als moralisches Subjekt und Gegenüber zu akzeptieren?

Zusammenfassung und Ausblick

Wie die oben ausgeführten Beispiele zeigen, führt die tiefgreifende soziotechnologische Transformation, die durch die Entwicklung von KI-Systemen angetrieben wird, zu neuen und spannenden Formen der Mensch-Technik Interaktion. Wir haben gesehen, dass unsere konzeptuellen Schablonen und ethischen Bewertungsmaßstäbe mitunter nicht ausreichen, die individualpsychologischen und gesellschaftlichen Spannungen dieser Konstellation abzufedern.

Verantwortung ist aus meiner Sicht ein tragfähiger und fruchtbarer Begriff, da er:

(1) diskursive Anschlussmöglichkeiten an unterschiedliche Disziplinen, wie Philosophie, Rechtswissenschaft, Ethik, Medizin und andere, bietet;

(2) Granularität hinsichtlich der jeweiligen Adressaten und avisierten Verantwortungsträger erlaubt, z.B. bezogen auf die Gesellschaft, nationale und supranationale politische Institutionen, industrielle Sektoren, bis hin zum Individuum;

(3) als normative Leit- und Begründungsfigur ein Gegengewicht bieten kann zu, erstens, den ökonomisch getriebenen Ansätzen großer Technologieunternehmen im Datenkapitalismus und, zweitens, einem dystopisch-autoritär motiviertem Einsatz von KI zur politischen Steuerung und Bevölkerungskontrolle, wie beispielsweise in dem chinesischen „Social Credit System“ (Munro, 2018).

Die nahe Zukunft wird zeigen, inwieweit es ein solcher „dritter Weg“ einer verantwortlichen künstlichen Intelligenz (responsible AI) schafft, unter Wahrung der Innovationsdynamik eine Governance-Struktur zu entwickeln, in der sich die Anwendungen der KI durchsetzen, die einer Entfaltung menschlicher Werte zuträglich sind (human flourishing) und das Allgemeinwohl nachhaltig und in gerechter Weise steigern.

Dr. med. Philipp Kellmeyer ist Facharzt für Neurologie am Universitätsklinikum Freiburg.

Links

Literatur

Esteva, A., Kuprel, B., Novoa, R. A., Ko, J., Swetter, S. M., Blau, H. M., & Thrun, S. (2017). Dermatologist-level classification of skin cancer with deep neural networks. Nature, 542(7639), 115–118. https://doi.org/10.1038/nature21056

Hinton, G. (2018). Deep Learning—A Technology With the Potential to Transform Health Care. JAMA, 320(11), 1101–1102. https://doi.org/10.1001/jama.2018.11100

Kellmeyer, P., Cochrane, T., Müller, O., Mitchell, C., Ball, T., Fins, J. J., & Biller-Andorno, N. (2016). The Effects of Closed-Loop Medical Devices on the Autonomy and Accountability of Persons and Systems. Cambridge Quarterly of Healthcare Ethics: CQ: The International Journal of Healthcare Ethics Committees, 25(4), 623–633. https://doi.org/10.1017/S0963180116000359

Lin, P., Abney, K., & Jenkins, R. (2017). Robot Ethics 2. 0: New Challenges in Philosophy, Law, and Society. Oxford University Press.

Munro, K. (2018, June 27). China’s social credit system ‘could interfere in other nations’ sovereignty’. The Guardian. Retrieved from https://www.theguardian.com/world/2018/jun/28/chinas-social-credit-system-could-interfere-in-other-nations-sovereignty

O’Neill, O. (2013). Science, Reasons and Normativity. European Review, 21(S1), S94–S99. https://doi.org/10.1017/S1062798713000197

Topol, E. J. (2019). High-performance medicine: the convergence of human and artificial intelligence. Nature Medicine, 25(1), 44–56. https://doi.org/10.1038/s41591-018-0300-7