Neue Technologien, alte Fragen. Verantwortung im medizintechnologischen Kontext

Von Wenke Liedtke (Greifswald) –

Kaum etwas hat unsere Welt und die Medizin in den vergangenen Jahrzehnten so verändert wie die Digitalisierung. Doch diese Fortschritte werfen Fragen auf: Wer trägt die Verantwortung, wenn ein Algorithmus eine fehlerhafte Diagnose stellt? Ist es ethisch vertretbar, Entscheidungen über Leben und Tod von Maschinen treffen zu lassen? Die Zukunft der Medizin ist spannend und faszinierend, aber auch abschreckend und skurril. Fragen nach Verantwortung im medizinischen Handeln sind nicht neu und begegnen uns schon in der Antike. Daher ist unweigerlich zu fragen, ob wir tatsächlich neue ethische Fragen aufwerfen oder in bekannten Debatten verharren, die lediglich in einem neuen Gewand erscheinen. Alter Wein in neuen Schläuchen? Oder ziehen wir neue ethische Grenzen, überschreiten wir sie gar?

Technologien, die Allgegenwärtigkeit der Begriffe „Algorithmen“ und „Künstliche Intelligenz“ (KI) beeinflusst schon jetzt Diagnosen, Therapien und das gesamte Gesundheitswesen in seinem strukturellen, professionellen, aktionalen, akteursbezogenen und wirtschaftlichen Sein. Wir sehen Veränderungen in den Ausbildungsinhalten der verschiedensten Gesundheitsberufe, hören von Ängsten des Berufsverlustes und wissen vom Gefühl des Nichtwissens der Patient:innen.[1]

Wenn wir neue Grenzen ziehen wollen oder an den alten festhalten, dann müssen wir bestimmen, warum solche neuen medizinischen Technologien und strukturellen Veränderungen wie die Digitalisierung zu Herausforderungen in unserer Welt führen können und wie wir sie mitigieren.

Warum beschäftigen sich Medizinethiker:innen so intensiv mit diesen technologischen Entwicklungen? Eine Antwort darauf liefert Hans Jonas in seinem Artikel „Warum die Technik ein Gegenstand für die Ethik ist: Fünf Gründe“ [2], der bereits mehr als 35 Jahre alt ist. In einer rasanten Welt also nicht mehr neu, trotzdem sind seine Überlegungen noch immer aktuell und bieten bis heute Einsichten zu den ethischen Herausforderungen technologischen Fortschritts.

Der jüdische Verantwortungsethiker Hans Jonas, der im 20. Jahrhundert mit zahlreichen technologischen Neuerungen konfrontiert wurde und sowohl die Chancen als auch die Herausforderungen dieser Technologie erlebte, argumentierte für einen bedächtigen Umgang mit der Einführung solcher. Während sein Hauptwerk von 1979 „Das Prinzip Verantwortung. Versuch einer Ethik für die technologische Zivilisation“[3] eine neue Ethik fordert und die Verantwortung als Generalprinzip in den Mittelpunkt stellt, erläutert er ein paar Jahre später gesondert und prägnant die Gründe für eine Auseinandersetzung mit Technologien überhaupt.

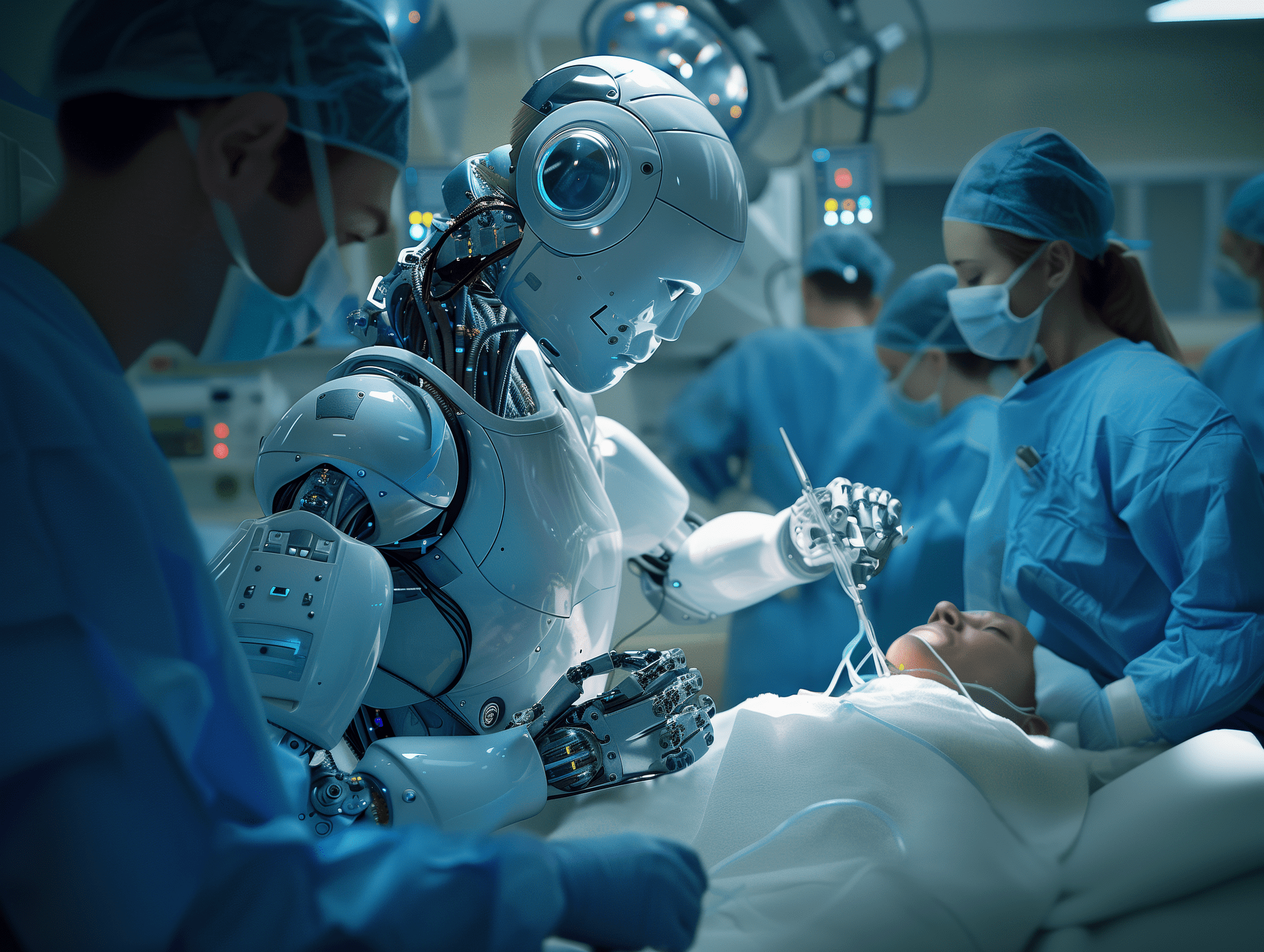

Für Jonas ist Technik „Ausübung menschlicher Macht“, „gesteigerte menschliche Macht“ und damit intentionale menschliche Handlung. Das wirft jedoch die Frage auf, inwiefern chirurgische Roboterassistenz oder Bildalgorithmen in der Radiologie sich von anderen, menschlichen Handlungen unterscheiden. Für Jonas liegt das Ausschlaggebende nicht in der Diskussion eines moralischen Status und der Subjektivierung moderner Technologie, vielleicht auch, weil dies noch nicht absehbar war, sondern in den potenziellen Folgen solcher Handlungen.

Daher kommt Jonas zu folgenden fünf Gründen, die für eine Beschäftigung mit Technologien in der Ethik sprechen:

- Ambivalenz der Wirkungen

- Zwangsläufigkeit der Anwendung

- Globale Ausmaße in Raum und Zeit

- Durchbrechung der Anthropozentrik

- Die Aufwerfung der metaphysischen Frage

Während die Gründe der Ambivalenz und der Zwangsläufigkeit in der heutigen Diskussion kaum hinterfragt werden, wohlweislich, dass immer im Raum steht, ob aus dem Können auch ein Sollen erwächst, lassen die drei nachfolgenden Gründe einen Eindruck auf den Gesamtumfang Jonas’ Denkens hinsichtlich der Anwendung neuer Technologien erahnen. Das betraf zu diesem Zeitpunkt vor allem atomare Entwicklungen und Fragen der Gentechnologien in der biomedizinischen Forschung.

Die Verantwortungsfrage umfasst bei Jonas nicht allein den Hinweis auf globale Raum- und Zeitumfänge der eigenen Lebensspanne, sondern erstreckt sich über den eigenen Lebenszeitraum und weitere Generationen hinaus. Gleichzeitig wird der Umfang über den Menschen als Objekte möglicher Konsequenzen der Einführung solcher Technologien erweitert. Der Blick richtet sich auch auf nicht-menschliches Leben oder nicht Lebendiges, wie es in der Umweltethik stark diskutiert wurde und wird.

In diesem Rahmen erscheint nun der letzte Grund „die Aufwerfung der metaphysischen Frage“ von besonderer Bedeutung, insofern damit die grundlegende Frage nach dem Menschsein und seinem Existenzrecht überhaupt aufgeworfen wird. Warum sollten wir uns über die Zukunft der Menschheit sorgen, wenn wir nicht annehmen, dass es einen Imperativ zur Existenz der Menschheit gibt? Nur wenn wir diese Bedingung annehmen, dann haben bekannte Fragen eine Relevanz: Was macht den Menschen aus? Was ist natürlich? Was ist künstlich? Wer wollen wir sein in 200 Jahren? Welche Grenzüberschreitungen könnten die Existenz der Menschheit gefährden?

Dies gilt es dann in der Auseinandersetzung zwischen technologischem Fortschritt und etwa der medizinischen Forschung und Anwendung zu beachten. Daraus erwächst die moralische Pflicht der Verantwortung für den Imperativ, mithin auch gegenüber nicht-menschlichen Leben.

Denn die Ambivalenz technologischer Entwicklungen zeigt sich darin, dass metaphorisch, wie Jonas gesprochen, Schwerter nicht nur zu Pflugscharen werden können, sondern Pflugscharen auch zu Schwertern. Während medizinisch-technologische Entwicklungen wie Herzschrittmacher dazu geführt haben, dass Menschen ein längeres und erfüllteres Leben führen können, kann es in der globalen Perspektive auch dazu führen, dass mehr Menschen auf dieser Welt leben und sich damit neue ethische Herausforderungen beispielsweise der Gerechtigkeit ergeben. Während KI-Algorithmen in der radiologischen Bildgebung dazu führen, dass etwa Hautkrebs früher diagnostizierbar wird und potenziell mehr Menschen geheilt werden, kann es auch dazu führen, dass wir nachlässiger mit dem Schutz unserer Haut werden. Wir könnten vergessen, dass wir vulnerable Wesen sind.

Jonas folgert, dass der technologische Fortschritt immer eine apokalyptische Tendenz inhäriert und der negativen Wirkungsbalance nur durch Entwicklung weiterer Technologien entgangen werden kann. Eine Abwärtsspirale droht. Dieses negative Technologieverständnis ist vor dem Hintergrund der Entwicklungen des 20. Jahrhunderts und der Wahrnehmung schädlicher Folgen, insbesondere atomarer Auswirkungen, verständlich. Jedoch werfen Jonas’ sprachintensive Äußerungen, wie die „angestammte Neigung zur Maßlosigkeit“ der Technik, die Frage auf, ob er diese damit nicht überschätzt. Nicht die Technik zeigt Maßlosigkeit, sondern der handelnde Mensch. Der verantwortliche Mensch ist angehalten, sich nicht von technologischen Errungenschaften abhängig zu machen und die eigenen Reflexionsfähigkeiten in Bezug auf technische Entwicklungen und das menschliche Sein beständig aufrechtzuerhalten. Für Jonas bedeutet das eine „mäßigende(r) Moral“, eine Moral, die sich dessen bewusst ist und entsprechend technologische Entwicklung mit Bedacht und Vorsicht in Hinblick auf mögliche Grenzüberschreitungen bewertet.

Das kann, um Jonas kritisch zu sehen, auch zur Verhinderung von technologischen Entwicklungen führen. Bildgebende KI-Verfahren oder Roboterassistenten im Operationssaal können effektiver sein als das menschliche Auge oder die menschliche Hand. Solche Verfahren können allerdings auch in anderen Prozessen mit weniger guten Absichten eingesetzt werden. Aber sollten wir deshalb, weil wir einen worst-case denken können, positive Auswirkungen solcher Technologien hintenanstellen? Die Heuristik der Furcht von Jonas kann zur Vermeidung positiver Auswirkungen für den Menschen und allen weiteren Lebens führen. Ich kann etwas denken, also werde ich es auch tun? Ist ein worst-case-Szenario ein angemessenes Abwägungskriterium?

Wenn die Norm der Verantwortung der Imperativ der Permanenz echten menschlichen Lebens ist, dann ist zu fragen, ob diese schon mit technischen Entwicklungen gefährdet ist. Ist von einem inhärenten Gefährdungspotential der Technologien auszugehen oder steckt dieses in den Menschen, die sie erzeugen? Noch erfindet sich Technologie nicht selbst.

Oder muss die Permanenz echten menschlichen Lebens präzisiert werden im Hinblick darauf, was Jonas als zentral für menschliches Leben erachtet? Wenn Jonas betont, dass Autonomie und Würde des Menschen maßgeblich sind, wird ersichtlich, welches Verständnis er vom menschlichen Leben im Kontext der Technologie vertritt. Der Mensch, ein freies und selbstständig reflektierend, denkendes Wesen, soll durch Einsatz von Technologie keinen Schaden erleiden, sondern möglichst einen Nutzen für das Wohlbefinden daraus ziehen.[4] So könnte Jonas auch gedacht werden.

Wenn Jonas so verstanden wird, dann wäre in der Medizintechnologie Bedacht in Entwicklung und Anwendung gefragt, gleichzeitig aber die Verantwortung gefordert, den Menschen mit Ängsten und Sorgen der verschiedensten Akteure der Gesundheitsberufe wahrzunehmen und diese zu verringern. Wenn wir fragen würden, wer wollen wir in 200 Jahren sein, dann wohl Menschen, die in medizinischer Mensch-Maschine-Interaktion frei und ohne Zwang, aber mit der Unterstützung von Technologien weiterhin, vielleicht mit leicht verschobenen Grenzen, immer noch das Gute wollen.

Wenke Liedtke ist promovierte wissenschaftliche Mitarbeiterin an der Theologischen Fakultät der Universität Greifswald. Ihre Forschungsschwerpunkte sind im Bereich der Medizin- und Technikethik und deren Herausforderungen angesiedelt. Insbesondere beschäftigt sie sich mit Verantwortungsfragen bei der Implementierung von KI-basierten Technologien in die medizinische Forschung und Versorgung.

https://theologie.uni-greifswald.de/lehrstuehle/ergaenzendes-lehrangebot/ethik-und-ihre-didaktik

[1] Friedrich, O., Seifert, J., Schleidgen, S. (Hg.), Mensch-Maschine-Interaktion – Konzeptionelle, soziale und ethische Implikationen neuer Mensch-Technik-Verhältnisse, Paderborn 2023.

[2] Jonas, H., Warum die Technik ein Gegenstand für die Ethik ist: Fünf Gründe, in: Lenk, H./ Ropohl, G. (Hg.): Technik und Ethik, rev. und erw., Stuttgart 21987, 83-91.

[3] Jonas, H., Das Prinzip Verantwortung. Versuch einer Ethik für die technologische Zivilisation, Neuausgabe mit einem Nachwort von Robert Habeck, Berlin 2020.

[4] Beauchamp, T. L., Childress, J. F., Principles of Biomedical Ethics, 8th Edition, New York/ Oxford 2019.